Découvrez Zero, la blockchain de type « Layer 0 » de LayerZero : un mélange entre les idées d’Ethereum, Solana, Avalanche, Cosmos et Polkadot, avec des améliorations sur les volets ZK, stockage, réseau et exécution, afin de proposer une blockchain capable d’offrir enfin une alternative aux systèmes puissants de fournisseurs de cloud centralisés comme Amazon AWS, Microsoft Azure ou encore Google Cloud.

Cet article est une traduction française de l’article « Zero : The Decentralized Multi-Core World Computer » publié par LayerZero le 11 février 2026. Si, comme nous, vous avez parfois du mal à comprendre les concepts techniques, particulièrement lorsqu’ils sont rédigés dans une langue autre que votre langue maternelle, cet article est fait pour vous.

Sommaire

- Zero : l’ordinateur mondial décentralisé multi-core

- Qu’est-ce qu’une blockchain ?

- Qu’est-ce qui rend une blockchain spéciale ?

- Principes de la blockchain

- L’essor d’Ethereum

- Les principes de décentralisation ont un coût

- L’essor de Solana

- Homogénéité

- Le noble mensonge

- Compute, Storage et Network : exécution, stockage & réseau

- Compression du Compute et du Network

- Le passage d’une architecture homogène à hétérogène

- Décentralisation

- Du Single Core au Multi-Core

- Quatre goulets d’étranglement de performance dans les blockchains

- La percée du Storage : QMDB

- Compute : repousser le plafond avec FAFO

- ZK : Scaler avec Jolt

- Network : le dernier goulet d’étranglement

- Le premier world computer multi-core

- Liens utiles

Zero : l’ordinateur mondial décentralisé multi-core

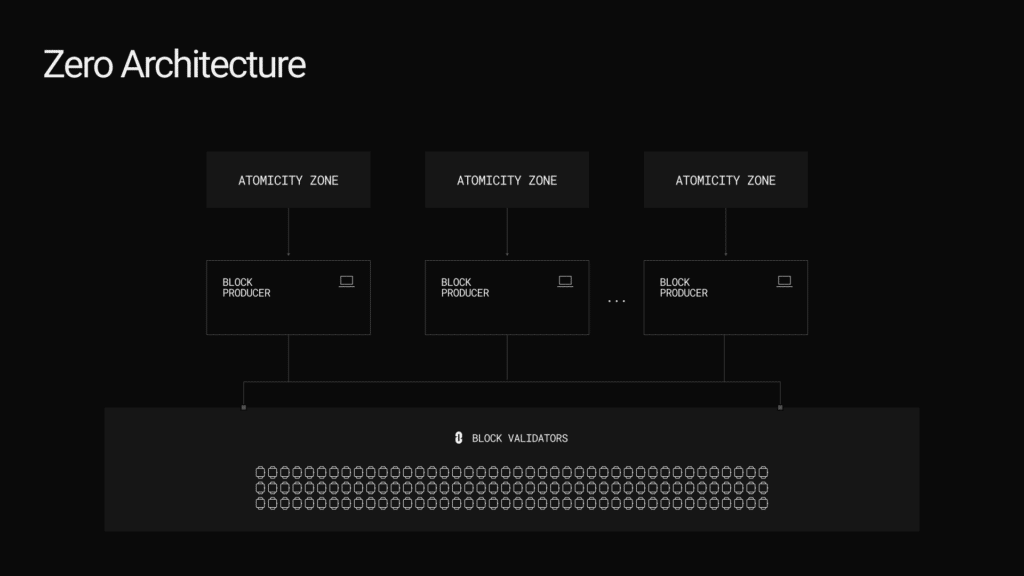

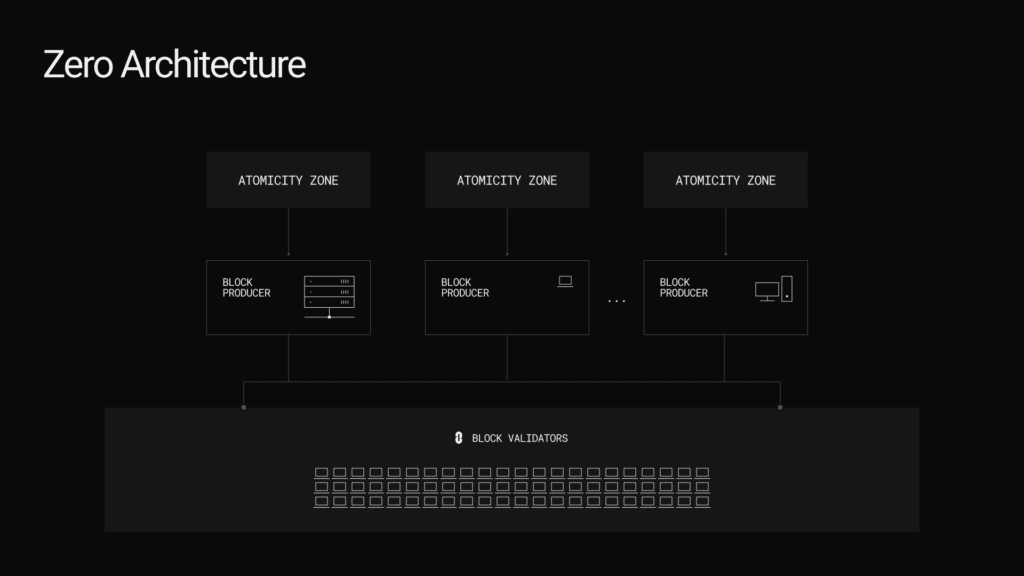

Zero introduit le premier ordinateur mondial multi-core, une rupture fondamentale avec les architectures single-threaded et homogènes qui limitent les blockchains actuelles. En s’appuyant sur les preuves Zero-Knowledge (ZK) pour découpler l’exécution de la vérification, Zero fait passer le réseau d’une réplication redondante à une architecture hétérogène. Ce changement structurel permet l’existence de deux classes distinctes de validateurs : des Block Validators légers, capables de fonctionner sur du matériel grand public bas de gamme, et des Block Producers optionnels à plus haute performance.

Le système atteint une feuille de route pratique de scaling à 2 millions de transactions par seconde (TPS) par Zone en résolvant quatre goulets d’étranglement principaux. Ces solutions comprennent QMDB pour le stockage d’état, FAFO pour l’ordonnancement parallèle du calcul, Jolt Pro pour la preuve ZK en temps réel, et SVID pour le réseau à haut débit. Zero fournit un environnement unifié, scalable horizontalement, où de multiples Atomicity Zones fonctionnent comme des processus concurrents sur un CPU moderne.

Le résultat est une infrastructure décentralisée capable d’offrir une alternative crédible aux fournisseurs de cloud centralisés.

Qu’est-ce qu’une blockchain ?

Pour comprendre comment la blockchain Zero de Layer Zero fonctionne, il faut d’abord comprendre les fondamentaux de la blockchain.

Une blockchain est une liste ordonnée de transactions regroupées en blocs. Chaque bloc est lié au précédent, ce qui rend l’historique sécurisé et permanent. Pour connaître l’état actuel du réseau, le système exécute ces transactions selon un ensemble spécifique de règles. Chaque nouveau bloc met à jour l’état.

L’état est résumé cryptographiquement en une racine d’état vérifiable (S) et stocké dans la blockchain. La racine d’état vous permet de vérifier des informations, comme le solde de votre compte, sans avoir à rejouer toutes les transactions.

Qu’est-ce qui rend une blockchain spéciale ?

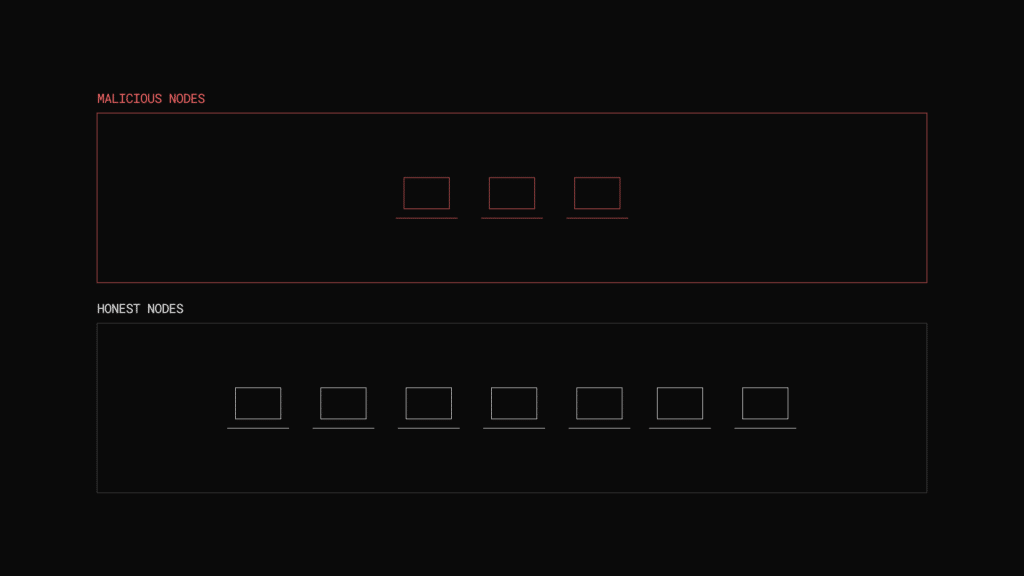

Rien de tout cela n’est intrinsèquement spécial comparé à une base de données. Ce qui rend une blockchain unique, c’est la décentralisation. Au lieu d’une autorité centrale, un groupe diversifié de participants permissionless, également appelés validateurs, s’accorde sur l’état. Plus le groupe est large, réparti à travers différentes juridictions et clients, plus le réseau sera robuste.

Ils suivent un protocole de consensus pour atteindre un accord de supermajorité sur chaque bloc. Cela garantit que le réseau reste sécurisé même si certains validateurs tentent de l’attaquer. Une blockchain fonctionne parce qu’un groupe suffisamment large peut toujours s’accorder sur la vérité, même si certains membres sont défaillants ou tentent de tricher.

Principes de la blockchain

Satoshi Nakamoto a créé Bitcoin en réponse directe à la crise financière de 2008. Cet effondrement a prouvé que les banques centralisées et les gouvernements ne peuvent pas être des garants fiables de notre sécurité collective.

L’objectif était de remplacer les systèmes fondés sur la confiance par un système décentralisé fondé sur des incitations économiques. Dans ce modèle, nous n’avons pas besoin que les validateurs soient « bons ». Nous avons seulement besoin qu’ils soient rationnels. En partant du principe que chaque acteur poursuivra son propre intérêt économique, le système transforme la recherche individuelle de profit en la force même qui sécurise le réseau.

Ces systèmes sont définis par trois principes fondamentaux :

- Décentralisation : aucun point de défaillance unique n’existe.

- Permissionless : personne ne peut vous empêcher de participer au protocole.

- Résistance à la censure : aucune autorité unique ne peut bloquer ou inverser vos transactions.

Ce changement redonne le pouvoir à l’individu grâce au self-custody. Lorsque vous détenez vos propres clés privées, votre patrimoine vous appartient. Les acteurs centralisés perdent la capacité de saisir, geler ou jouer avec vos actifs. C’est la rupture définitive avec un système obsolète où votre argent n’est qu’un passif au bilan d’une banque.

L’essor d’Ethereum

Ces principes fondamentaux ont conduit à d’autres blockchains qui voulaient offrir plus qu’une simple réserve de valeur. Cela a déclenché l’essor d’Ethereum. Son objectif était de construire un world computer (ordinateur mondial) crédiblement neutre et programmable. C’était l’avènement d’un internet nouveau, décentralisé et permissionless.

Du point de vue des validateurs, Ethereum n’exécute qu’une seule application : l’Ethereum Virtual Machine (EVM).

On peut comparer l’EVM à un système d’exploitation comme MacOS. Quand un ordinateur fait tourner MacOS, le matériel ne reconnaît pas les applications spécifiques que vous utilisez. Il exécute uniquement le système d’exploitation et suit les instructions que l’OS fournit. L’EVM fonctionne de la même manière. Elle permet aux développeurs de lancer des applications en utilisant des smart contracts.

Le premier véritable succès a été la finance. Les développeurs ont construit des applications financières qui fonctionnaient sans banques. Naturellement, les gens ont essayé de construire tout le reste aussi, y compris les réseaux sociaux et les jeux.

Mais ils ont frappé un mur. Faire tourner ces applications sur une blockchain coûtait infiniment plus cher que d’utiliser les services « Web2 » traditionnels. À mesure que les utilisateurs affluaient, le world computer d’Ethereum ne pouvait pas suivre. Finalement, même les applications financières peinaient à croître parce que le système était trop lent et les frais trop élevés.

Le rêve d’un internet décentralisé était réel, mais l’infrastructure n’était pas prête à supporter l’échelle. Pourquoi ne peut-il pas scaler ?

Sur Ethereum, les validateurs se relaient pour proposer de nouveaux blocs. Quand un validateur est choisi, il regroupe les transactions pour créer un bloc. Ensuite, le reste des validateurs doit s’accorder dessus.

Le problème d’Ethereum, c’est qu’il n’est pas très efficient. Pour rester synchronisé et vérifier l’état, chaque validateur du réseau doit télécharger et réexécuter chaque transaction.

Si vous envoyez une transaction, des milliers d’ordinateurs à travers le monde effectuent tous exactement le même calcul pour confirmer le solde de votre compte. Cette duplication constante du travail crée un goulet d’étranglement massif. Parce que le réseau ne peut aller qu’à la vitesse de son maillon le plus faible, il ne peut pas scaler.

Les principes de décentralisation ont un coût

Pour rester décentralisé, Ethereum doit maintenir des exigences matérielles modérées. Cela garantit que presque n’importe qui peut faire tourner un nœud depuis chez soi. Cependant, cela crée un goulet d’étranglement majeur : le world computer ne peut avancer qu’à la vitesse d’un seul ordinateur peu puissant.

Quand trop de personnes utilisent le réseau en même temps, elles doivent se battre pour l’espace limité à l’intérieur de chaque bloc. Cela déclenche une guerre d’enchères. Les utilisateurs doivent payer des frais plus élevés pour utiliser la blockchain.

Cela rend le réseau trop cher pour tout ce qui n’est pas du trading à haute valeur. Plus le système devient populaire, moins il devient utile pour les applications du quotidien comme les jeux ou les réseaux sociaux, parce que leurs utilisateurs ne peuvent pas se permettre les frais.

Parce qu’Ethereum a choisi de privilégier des exigences matérielles modérées, de nouveaux concurrents sont apparus pour offrir un « world computer » plus performant. Place à Solana.

L’essor de Solana

Comme Ethereum, Solana exécute sa propre application appelée la Solana Virtual Machine (SVM). Solana a massivement augmenté les exigences matérielles des validateurs pour booster les performances. Cela permet au réseau de traiter des milliers de transactions par seconde, mais au prix des principes fondamentaux.

En relevant la barre matérielle, Solana a rendu la participation bien plus coûteuse. Les exigences de Solana sont si élevées que seuls ceux disposant de configurations spécialisées et professionnelles peuvent se permettre de faire tourner un validateur. Cela éloigne le système d’une décentralisation généralisée pour aller vers un groupe plus restreint et concentré d’opérateurs bien capitalisés.

Homogénéité

La faille architecturale est la même pour toutes les blockchains. Elles sont homogènes. La croyance commune est que pour être un world computer, chaque nœud du réseau doit télécharger, traiter et parvenir à un consensus sur chaque transaction. Pour cela, chaque nœud doit être identique. Cela augmente les coûts de manière drastique à mesure que l’on optimise le réseau pour de meilleures performances. Fondamentalement, cette architecture ne peut pas scaler sans compromettre les principes fondamentaux.

Le noble mensonge

En 2020, Ethereum faisait face à une menace existentielle. Les nouvelles blockchains choisissaient la performance au détriment des principes fondamentaux. Le propre plan d’Ethereum pour scaler son Layer 1 (L1) via le sharding avançait trop lentement, et le réseau perdait son avance.

Incapable de scaler le L1 rapidement, Ethereum a réorienté sa stratégie vers une feuille de route centrée sur les Layer 2. Ces Layer 2 (L2), ou rollups, sont des blockchains centralisées qui publient leurs données sur le Layer 1 Ethereum.

La promesse d’Ethereum était que ces systèmes finiraient par hériter de la décentralisation et de la sécurité du Layer 1 (réseau principal).

Mais il y a une faille fondamentale. Les Layer 2 ne peuvent jamais abandonner le contrôle sur le séquençage des blocs, la logique des smart contracts et les feuilles de route fonctionnelles.

Toutes les blockchains évoluent par le biais de validateurs qui atteignent un consensus pour mettre à jour leur application. Cependant, un L2 ne peut pas hériter de la sécurité d’un L1 sans perdre cette capacité. Pour être véritablement sécurisé par le L1, le L2 devrait renoncer à ses privilèges de mise à jour, rendant sa logique verrouillée et immuable.

Cela crée un paradoxe qui prouve que la promesse des Layer 2 a toujours été un mensonge :

- Si un L2 est verrouillé et décentralisé : il devient une impasse. Il ne peut ni innover ni s’adapter, ce qui le rend obsolète face à tous les autres réseaux en évolution.

- Si un L2 peut être mis à jour : il est centralisé et contrôlé par un petit groupe de personnes ayant le pouvoir de changer les règles.

Ethereum nous raconte ce mensonge pour faire face à une dure vérité : ils ont abandonné leurs principes pour rester compétitifs. Ils ont arrêté de construire le world computer. Au lieu de cela, ils ont poussé les utilisateurs loin d’une blockchain décentralisée, permissionless et résistante à la censure, vers des blockchains centralisées et censurables, et ils ont appelé ça du scaling.

Ce mensonge est ce qui nous a poussés à créer Zero.

Compute, Storage et Network : exécution, stockage & réseau

Tout commence par les bases. Comme tout ordinateur, une blockchain est limitée par trois choses :

- Compute : exécuter du code pour transformer des inputs en outputs.

- Storage : sauvegarder et récupérer les outputs (données en sortie).

- Network : communiquer avec d’autres ordinateurs et Internet.

Pour augmenter la performance de n’importe quel système, il faut faire des compromis entre ces trois domaines.

Compression du Compute et du Network

Dans une blockchain standard, chaque validateur doit télécharger et exécuter chaque transaction pour s’assurer que les données sont correctes. C’est le problème de la réplication. Il ne crée pas seulement un goulet d’étranglement ; il augmente les coûts et impose une charge massive aux validateurs qui doivent tout télécharger et traiter.

Les preuves Zero Knowledge (ZK) résolvent ce problème. Elles permettent de vérifier mathématiquement qu’un output est correct sans avoir à exécuter le code soi-même. Au lieu que chaque validateur réexécute chaque transaction, ils vérifient simplement une minuscule preuve et sautent le travail.

Cela signifie que les validateurs n’ont plus besoin de rejouer l’historique. En fait, ils n’ont même plus besoin de télécharger les données brutes de chaque bloc, juste une preuve que les transactions existent. Cette prise de conscience : pouvoir libérer la réplication du compute et du network, nous a conduits au design inévitable de Zero.

Le passage d’une architecture homogène à hétérogène

Chaque blockchain décentralisée part du même principe : un ensemble de validateurs qui parviennent à un consensus sur des blocs de transactions. Zero n’est pas différent.

Dans les blockchains existantes, chaque validateur exécute ces transactions à travers une application unique, par exemple l’EVM. Zero fait conceptuellement la même chose. Nous appelons les applications de Zero des Atomicity Zones ou zones atomiques, c’est à dire des Zones d’intégrité garantie.

La différence avec Zero, c’est que les validateurs téléchargent des données et des preuves de calcul au lieu de télécharger et rejouer chaque transaction. Cela réduit drastiquement les besoins en bande passante et en puissance de calcul pour chaque validateur.

Pour la première fois dans l’histoire, les validateurs d’une seule blockchain n’ont pas à répliquer le même travail. C’est la percée structurelle qui déverrouille une architecture hétérogène.

Toutes les autres blockchains fonctionnent sur un design homogène. Dans ces systèmes, les nœuds sont des clones identiques qui téléchargent les mêmes données et rejouent chaque transaction. Bien que cela maintienne la chaîne synchronisée, cela piège le réseau dans un cycle de travail manuel redondant.

Si Zero utilisait les preuves ZK dans ce même cadre homogène, ce serait un échec de conception. Les preuves ZK sont vérifiées en millisecondes, donc chaque validateur terminerait sa tâche instantanément puis resterait inactif, gaspillant les ressources qu’il a été contraint de provisionner.

Pour capitaliser sur le déverrouillage ZK, Zero scinde le réseau en deux classes fonctionnelles distinctes : les Block Producers et les Block Validators.

- Les Block Producers construisent les blocs à tour de rôle, exécutent les transitions d’état et génèrent les preuves cryptographiques.

- Les Block Validators ingèrent simplement les en-têtes de blocs et vérifient les preuves.

Ce changement altère fondamentalement les exigences économiques du réseau. Sur Ethereum, chaque validateur doit posséder la puissance de calcul pour faire tourner la VM complète. Cette redondance massive force le coût collectif de maintenance d’un réseau de cette envergure à environ 50 millions de dollars par an.

Zero supprime l’obligation pour chaque nœud d’être un clone. En séparant l’exécution de la vérification, un réseau avec le même débit et la même décentralisation qu’Ethereum peut fonctionner pour moins d’1 million de dollars. La décentralisation à l’échelle mondiale ne vient pas du fait de rendre les validateurs plus puissants, mais de leur faire faire moins.

Décentralisation

Les Block Producers regroupent les transactions en blocs et génèrent des preuves pour booster la performance. Cependant, les validateurs ont l’autorité finale sur les blocs acceptés. Cela empêche tout Block Producer unique d’agir comme un gardien et garantit que les Atomicity Zones sont résistantes à la censure.

Zero est sécurisé par le Delegated Proof of Stake (dPoS). Les stakers de ZRO délèguent leurs tokens aux validateurs qui font tourner le réseau. Pour s’assurer que tout le monde puisse participer, nous avons supprimé les exigences de stake minimum élevées et éliminé le slashing automatique au niveau de la couche de consensus. Cela uniformise les règles du jeu, en supprimant les obstacles économiques systématiques qui poussent habituellement les validateurs domestiques en faveur des staking pools géants.

La même logique s’applique à la gouvernance du réseau. Tout changement majeur, comme une mise à jour du protocole ou l’ajout d’une nouvelle Zone, nécessite un vote on-chain par les stakers. C’est pourquoi Zero est une blockchain unique et sécurisée : il n’y a aucun conseil externe qui met à jour les Zones, tout est entièrement détenu par la couche de gouvernance décentralisée. Mais nous savons que la plupart des gens n’ont pas le temps d’auditer du code complexe ou des whitepapers économiques.

Pour résoudre cela, Zero utilise un modèle de Sénateurs.

- Expertise guidée : les Sénateurs sont des experts reconnus dans des domaines comme la cryptographie et l’économie, alignés avec la mission de Zero.

- Délégation intelligente : en tant que staker, vous pouvez déléguer votre pouvoir de vote à un Sénateur de confiance, garantissant que le réseau est guidé par des décisions éclairées.

- Non-custody : vous ne perdez jamais votre voix. Vous pouvez annuler une délégation et voter directement sur n’importe quelle proposition, à tout moment.

Ce dispositif permet au réseau de bénéficier d’une expertise de haut niveau tout en gardant l’autorité finale là où elle doit être : entre les mains des parties prenantes.

Du Single Core au Multi-Core

Si l’architecture de Zero peut égaler la décentralisation d’Ethereum tout en n’utilisant qu’une fraction de ses ressources, cela ouvre une opportunité majeure. Essentiellement, Zero laisse des quantités massives de puissance réseau et de compute sur la table.

La plupart des blockchains sont single-threaded. Elles agissent comme un vieil ordinateur avec un processeur single-core qui ne peut faire tourner qu’une application à la fois. Parce que chaque nœud du réseau doit répéter chaque instruction, l’ensemble du world computer est limité par la vitesse de ce seul cœur.

Zero brise cette contrainte. Puisque nous ne gaspillons plus de ressources en travail dupliqué, le réseau est libre d’exécuter de nombreuses applications en parallèle. Cela permet au système de gérer un volume massif de transactions simultanément sans ralentir.

Pensez-y comme le saut du processeur single-core au multi-core. Dans l’ancien modèle, si vous vouliez lancer une nouvelle application, vous deviez entrer en concurrence avec tout le monde pour les mêmes cycles limités. Zero a la capacité de faire tourner des centaines d’applications simultanément à travers différentes Atomicity Zones.

En passant à une architecture multi-core, nous ne scalons pas seulement une application unique ; nous scalons l’écosystème entier. Zero peut faire tourner une bourse de trading haute fréquence dans une Zone, un protocole de réseau social dans une autre, et un système de paiements privé dans une troisième, le tout sans qu’ils se disputent les mêmes ressources.

Quatre goulets d’étranglement de performance dans les blockchains

Il y a deux ans et demi, c’était l’architecture que nous avons entrepris de construire avec Zero. Notre objectif initial était de créer une blockchain aussi décentralisée, permissionless et résistante à la censure qu’Ethereum, mais avec la performance de Solana. Pour y arriver, nous devions résoudre les goulets d’étranglement de scaling qui affligent cette industrie en repartant des premiers principes.

Notre parcours a commencé par une attaque simultanée sur le storage (stockage) et le ZK (Zero Knowledge).

La percée du Storage : QMDB

Au-delà du compute (exécution) et du network (réseau), le state storage est l’un des plus gros goulets d’étranglement pour le scaling. Pendant des années, l’industrie a supposé que les blockchains devaient utiliser des structures de données basées sur des tries. Ces structures sont incroyablement inefficientes parce qu’elles écrivent la structure du trie sur le disque, gaspillant le potentiel haute vitesse des SSD modernes.

Nous avons réalisé que la solution était un changement fondamental dans l’architecture des données. Au lieu de suivre le modèle de trie legacy, nous sommes passés à une structure basée sur des logs, en append-only, conçue spécifiquement pour les I/O (input/output) haute vitesse des SSD modernes. Nous avons ensuite ajouté la vérifiabilité directement par-dessus cette fondation optimisée.

Le résultat est QMDB (Quick Merkle Database), la base de données vérifiable la plus rapide au monde. Son design est optimal à 92 % théoriquement, lui permettant de traiter 3 millions de mises à jour par seconde.

Cette performance n’est pas une amélioration marginale. C’est 100x plus rapide que les bases de données d’état blockchain existantes et 6x plus rapide que RocksDB de Facebook. Nous considérions auparavant le débit de Solana comme le plafond du possible, mais QMDB a prouvé que le storage n’est pas le goulet d’étranglement, et que le plafond est assez haut pour supporter des applications comme le NYSE avec plus de 2 millions de transactions par seconde. Ce nombre est devenu notre objectif pour chaque goulet d’étranglement restant dans le système. En résolvant le storage, Zero a supprimé la première barrière physique au véritable passage à l’échelle mondiale.

Compute : repousser le plafond avec FAFO

Une fois que QMDB a atteint 3 millions de mises à jour par seconde, il est devenu clair que le plafond théorique de débit était significativement plus élevé que ce que les standards de l’industrie suggéraient. Le storage étant optimisé, le goulet d’étranglement principal s’est déplacé vers le compute. Plus précisément, le réseau avait besoin d’une méthode pour traiter les transactions sans les conflits d’ordonnancement inhérents aux charges de travail blockchain traditionnelles.

La plupart des blockchains traitent les transactions de manière sérielle. Même lorsque les tâches ne sont pas liées, elles sont forcées dans une file unique pour éviter les erreurs. Cette exigence séquentielle empêche le système de scaler, quelle que soit la quantité de matériel fourni.

Nous avons inventé FAFO (Fast Ahead of Formation Optimization) pour résoudre ce problème.

FAFO permet l’exécution parallèle, similaire à Solana, mais avec une différence critique dans notre algorithme d’ordonnancement sophistiqué et une expérience développeur supérieure. Alors que Solana exige que l’utilisateur ou le développeur spécifie manuellement quels slots de storage une transaction va toucher, FAFO effectue cette analyse automatiquement. Il identifie les transactions non conflictuelles et les réordonne pour une exécution parallèle sans transférer la charge sur l’utilisateur.

Bien que FAFO ne résolve pas le problème de surcharge (congestion) quand de nombreuses transactions accèdent aux mêmes données en même temps, il isole leur impact sur les performances. Cela garantit qu’un pic de demande pour une application spécifique n’augmente pas les coûts pour les autres. Les applications non contestées continuent d’accéder à un block space bon marché, indépendamment de la congestion ailleurs.

Le changement architectural est significatif. FAFO permet une performance 2 500x plus rapide que la BNB Chain, avec un seul nœud dépassant 1,2 million de transactions EVM par seconde.

En éliminant l’exécution en série, l’EVM scale enfin.

ZK : Scaler avec Jolt

Pendant la construction de QMDB, nous avons également évalué le paysage Zero-Knowledge (ZK). Nous avons constaté que la plupart des zkVM existantes arrivaient en fin de cycle de vie ; elles étaient construites sur des architectures vieillissantes qui ne pouvaient pas répondre à nos exigences pour le passage à l’échelle mondiale.

Parmi les options, nous avons identifié Jolt comme un framework émergent et prometteur que nous estimions capable de propulser le world computer. L’architecture de Jolt est fondamentalement plus simple et plus efficiente que les autres systèmes de preuves.

Nous avons constitué une équipe de cryptographes de classe mondiale pour construire sur cette fondation et créer Jolt Pro, qui prouve RISC-V à plus de 1,61 GHz par cellule avec une feuille de route claire vers 4 GHz d’ici 2027.

Pour mettre cela en perspective, 4 GHz est l’équivalent d’un seul cœur sur un CPU haut de gamme moderne. Nous pouvons scaler ces cellules à l’infini et ne sommes limités que par la quantité de GPU dans le datacenter.

Jolt Pro prouve RISC-V environ 100x plus vite que les zkVM existantes. Ce bond est ce qui rend enfin le calcul vérifiable en temps réel praticable.

Network : le dernier goulet d’étranglement

Résoudre le stockage, le compute et le ZK nous a laissés avec une dernière barrière : le stockage de blocs tolérant aux pannes. Les blockchains standard sont limitées parce que chaque validateur doit télécharger chaque transaction. Dans notre architecture, les validateurs n’ont besoin que d’une preuve d’engagement cryptographique de la transaction et d’une fraction des données associées. C’est une minuscule empreinte cryptographique prouvant que les données sont récupérables, soit une quantité d’information dramatiquement plus petite : moins de 0,5 % des données originales du bloc pour un bloc de 128 MiB.

Pour scaler ces engagements, nous avons créé SVID (Scalable Verifiable Information Dispersal). Il délivre théoriquement un débit massif de 10 GiB/s, soit plus de 1 000x plus rapide que PeerDAS d’Ethereum.

En s’assurant que les validateurs ne téléchargent que le strict minimum, nous avons franchi le dernier obstacle pour atteindre 2 millions de TPS par Zone.

Le premier world computer multi-core

L’avancée dans le networking complète le cercle architectural. En découplant la disponibilité des données de la validation, SVID permet au réseau de gérer des charges massives sans submerger les nœuds individuels. Combiné avec QMDB pour le stockage, FAFO pour l’ordonnancement des transactions et Jolt Pro pour les preuves ZK, le réseau n’est plus un goulet d’étranglement.

Deux millions de transactions par seconde sont devenus notre objectif explicite pour chaque composant du système. En atteignant cette cible, Zero peut supporter les applications modernes les plus performantes.

Cette architecture permet à Zero de fonctionner comme un world computer décentralisé multi-core.

Point crucial : les Zones ne sont pas des chaînes souveraines, des Layer 2 ou des rollups.

Chaque Zone est possédée par Zero et gouvernée par le même protocole unifié. La plupart des blockchains, y compris Ethereum, sont single-threaded ; elles tournent sur un seul cœur. Zero tourne sur plusieurs. Chaque Zone est fonctionnellement équivalente à la seule EVM qu’Ethereum exécute, mais nous les exécutons simultanément sur plusieurs cœurs.

Le résultat est une blockchain unique qui scale horizontalement. Les développeurs n’ont pas besoin de créer leurs propres Zones ; ils construisent des applications par-dessus les Zones que Zero fournit. Nous avons remplacé le modèle fragmenté, taille unique, par un système haute performance unifié qui traite de multiples applications comme des processus concurrents sur un seul CPU multi-core moderne.

Grâce à cette réduction massive des coûts, Zero n’est pas seulement une alternative aux blockchains existantes ; il offre une alternative crédible aux fournisseurs de cloud centralisés comme AWS. En supprimant la surcharge de la réplication redondante, nous avons enfin rendu la décentralisation viable à l’échelle mondiale.

Zero est le premier world computer multi-core véritablement scalable.

Liens utiles

👀 Zero : document de positionnement technique

🐦 Article Twitter de Layer Zero